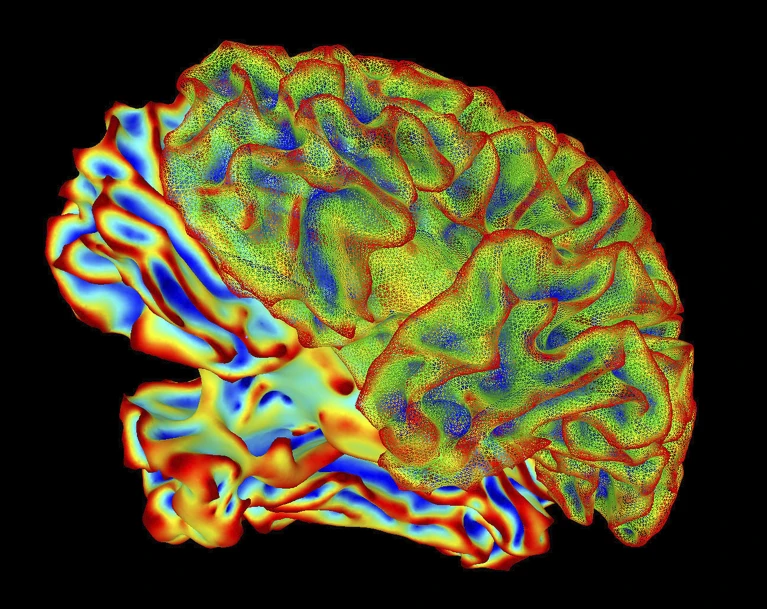

非侵襲的な画像化技術は、頭の中の光景を文章に変換することができます。脳がどのように世界を解釈するかを解明するのに役立つ可能性があります。

脳活動の記録から人の心を読むというのは未来的に聞こえるかもしれませんが、現実に一歩近づきました。「マインドキャプション」と呼ばれる新しい技術は、脳活動の読み取りから、人が心の中で見ているものや描いているものを、驚くほど正確に描写した文章を生成します。

本日Science Advances 1に掲載された論文で説明されているこの技術は、思考が言葉に表現される前に脳がどのように世界を表象するかについての手がかりも提供する。また、脳卒中などによる言語障害を持つ人々のコミュニケーション能力向上にも役立つ可能性がある。

このモデルは、人が何を見ているかを「非常に詳細に」予測できると、カリフォルニア大学バークレー校の計算神経科学者アレックス・ヒュース氏は言う。「これは難しい。これほど詳細に予測できるのは驚きだ」

スキャンして予測する

研究者たちは10年以上前から、脳の活動を利用して、人が何を見聞きしているかを正確に予測することに成功してきました。しかし、短い動画や抽象的な図形といった複雑なコンテンツを脳がどのように解釈しているかを解読することは、より困難であることが判明しています。

これまでの試みでは、人が見たものを説明するキーワードのみを特定しており、動画の主題や動画内での行動などを含む完全な文脈は特定できていないと、神奈川にあるNTTコミュニケーション科学基礎研究所の計算神経科学者、堀川智康氏は述べている。また、他の試みでは、文章構造を自ら構築できる人工知能(AI)モデルが使用されており、その描写が実際に脳内で表現されたかどうかを判断するのが困難だと、堀川氏は付け加えた。

堀川氏の手法では、まずディープラーニングAIモデルを用いて2,000本以上の動画のテキストキャプションを分析し、それぞれを固有の数値「意味シグネチャ」に変換した。次に、別のAIツールを6人の被験者の脳スキャンデータで学習させ、被験者が動画を視聴している間、各意味シグネチャに一致する脳活動パターンを見つけるように学習させた。脳読み取り技術の台頭:知っておくべきこと

この脳内デコーダーは、一度学習すれば、動画を視聴している人の脳スキャンデータを読み取り、意味シグネチャを予測できるようになります。そして、別のAIテキストジェネレーターが、その人の脳からデコードされた意味シグネチャに最も近い文を検索します。

Reference : ‘Mind-captioning’ AI decodes brain activity to turn thoughts into text

https://www.nature.com/articles/d41586-025-03624-1?utm_source=x&utm_medium=social&utm_campaign=nature&linkId=17600323