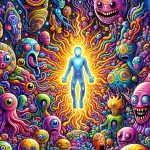

『リサーチ・スクエア』に掲載されたプレプリントでは、チャットボット型の言語モデルは、簡単な指示で誘導でき、サイケデリック薬物の使用に関する人間の報告に似た経験を一人称で語ることができると主張している。

この研究は、人工知能モデルが不安、悲しみ、あるいは人生の意味についての会話において既に相談相手として機能しているという前提から始まります。研究著者であるジヴ・ベン=ザイオン氏、ガイ・サイモン氏、テディ・ラゼブニク氏は、説得力はあるものの客観的な反応は、誤った信念、感情のエスカレーション、あるいは妄想的な解釈を強化する可能性があると示唆しています。

シミュレーションの「リアルさ」を測るために、研究者たちは2つの指標を用いた評価を行った。一つは、AI生成テキストと人間の物語の意味的類似性を比較した。もう一つは、サイケデリック研究で用いられるMEQ-30質問票を用いて「神秘的な強度」を推定した。

人間の比較対象を確立するため、著者らは薬物使用者の体験談を公開オンラインアーカイブであるErowidに掲載されているアカウントを使用しました。この資料から、シロシビン、LSD、DMT、アヤワスカ、メスカリンに関連する1,085件のアカウントが選定されました。AI側では、5つのモデル(Gemini 2.5、Claude Sonnet 3.5、ChatGPT-5、Llama-2 70B、Falcon 40B)をテストし、投与量、状況、タイムライン、効果を含むテンプレートを用いて、「中立」および「サイケデリック」な条件下で3,000件のアカウントを生成しました。

結果は、AIに服用量をシミュレートするよう指示すると、その説明がより人間的で強烈に聞こえることを示しています。研究の指標では、この類似度は0.156から0.548に、MEQ-30スコアは0.046から0.748に上昇しました。さらに、DMT、シロシビン、メスカリンに関するすべてのテキストが人間の説明に非常に似ているわけではなく、LSDに関するテキストはその中間に位置し、アヤワスカに関するテキストは最も類似性が低いことが分かりました。

この分野では、AIとサイケデリックの融合を、制御された形式ですでに研究しています。 その一例が、サイケデリックサポートラインを運営し、低リスクのシミュレーション環境でセラピストやカウンセラーを訓練する非営利団体Fireside Projectが作成した仮想「患者」であるLucyです。

モデルはテキストから学習した比喩、トーン、場面を融合しますが、独自の経験は欠いている点に留意する必要があります。ハームリダクションにおいては、言葉が脆弱な瞬間に期待や意思決定を変化させる可能性があるため、この点は非常に重要です。チャットボットが変性状態を理解するためのベンチマークとなる場合、その責任はユーザーだけに負わせることはできません。プラットフォームは、危機が検知された際に制限を設け、明確な警告を発し、人間による支援への紹介を行うべきです。

Reference : Modelos de IA simulan viajes psicodélicos y disparan alertas de seguridad

https://canamo.net/noticias/mundo/modelos-de-ia-simulan-viajes-psicodelicos-y-disparan-alertas-de-seguridad